CSIG中国行

CSIG图像图形中国行—苏州科技大学站-129

时间:2024-05-23 来源: 中国图象图形学学会

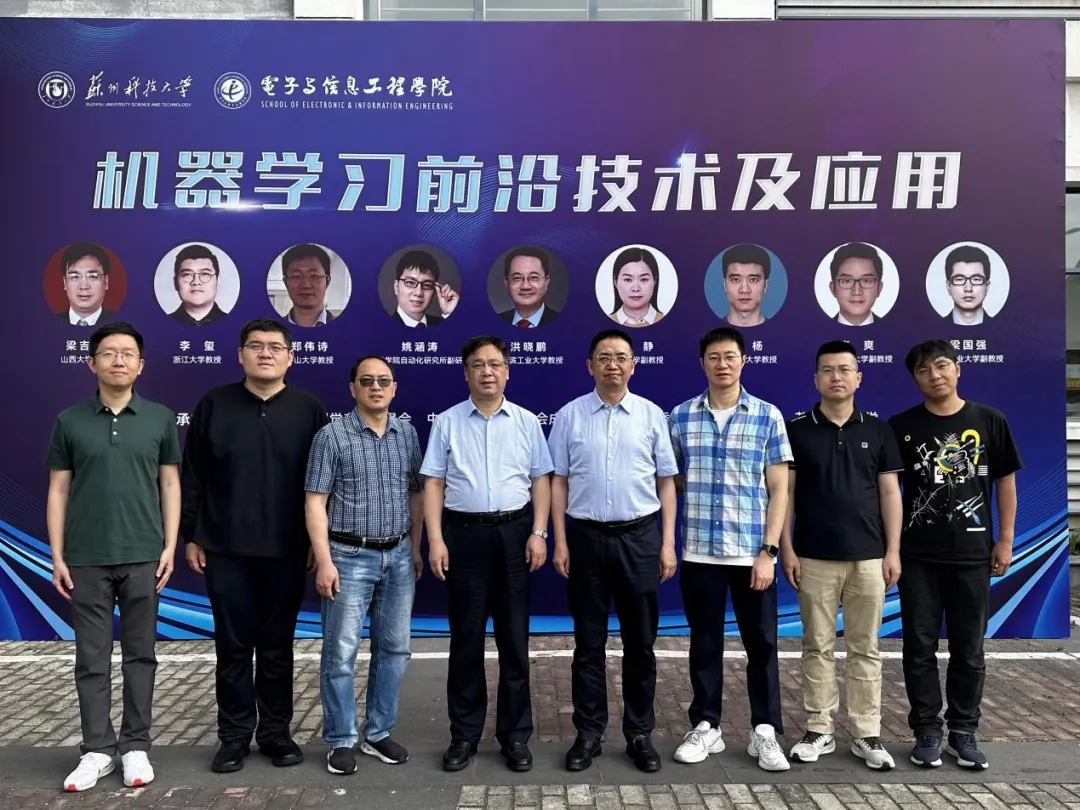

2024年5月20日,由中国图象图形学学会(CSIG)主办、CSIG成像探测与感知专业委员会及苏州科技大学承办的CSIG图像图形中国行报告会以线上线下相结合的方式在苏州科技大学成功举办。出席出席本次活动的嘉宾有山西大学梁吉业教授、浙江大学李玺教授、中山大学郑伟诗教授、中国科学院自动化研究所姚涵涛副研究员、哈尔滨工业大学洪晓鹏教授、南京大学霍静副教授、南京理工大学杨杨教授、北京理工大学李爽副教授和西北工业大学梁国强副教授。

苏州科技大学校长顾菊平教授与苏州科技大学副校长肖洋教授参加了本次报告会。苏州科技大学副校长肖洋教授为报告会致欢迎词,肖洋教授对各位专家学者的到来表示热烈的欢迎和衷心的感谢,并预祝本次活动取得圆满成功。本次会议执行主席为苏州科技大学电子与信息工程学院院长胡伏原教授,中国计算机学会(CCF)苏州分部主席龚声蓉教授、苏州科技大学讲师程涵婧、江南大学赵少川博士。

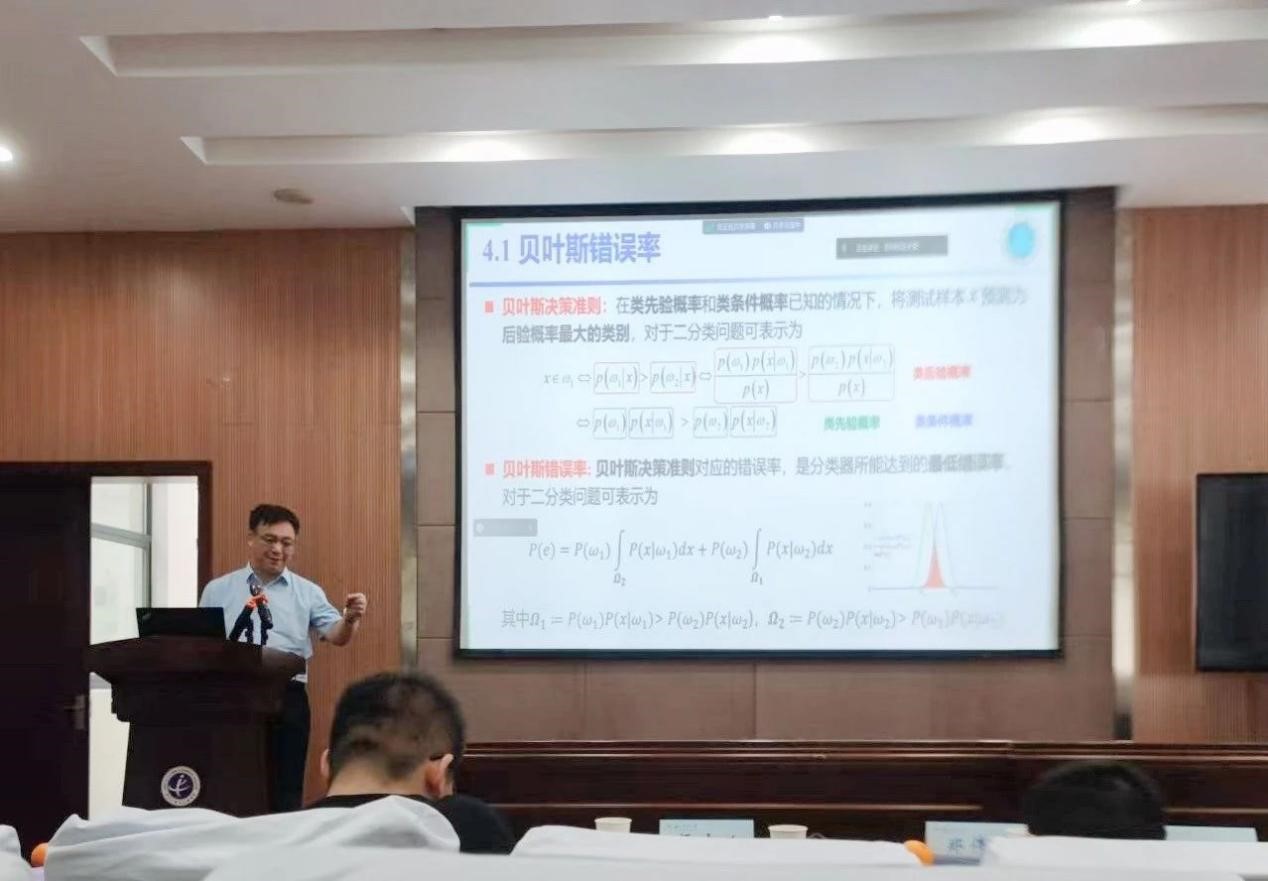

图 1 梁吉业教授作报告

梁吉业教授的主题报告围绕机器学习方法的性能严重依赖数据的表示展开。梁老师首先介绍表示学习的相关背景、主要方法及关键问题;接着聚焦概念认知、泛化误差和贝叶斯错误率,介绍上述三个视角下的表示学习最新研究进展;最后梁老师分享了对表示学习的一点思考,为未来的研究提供了宝贵的启示和方向。

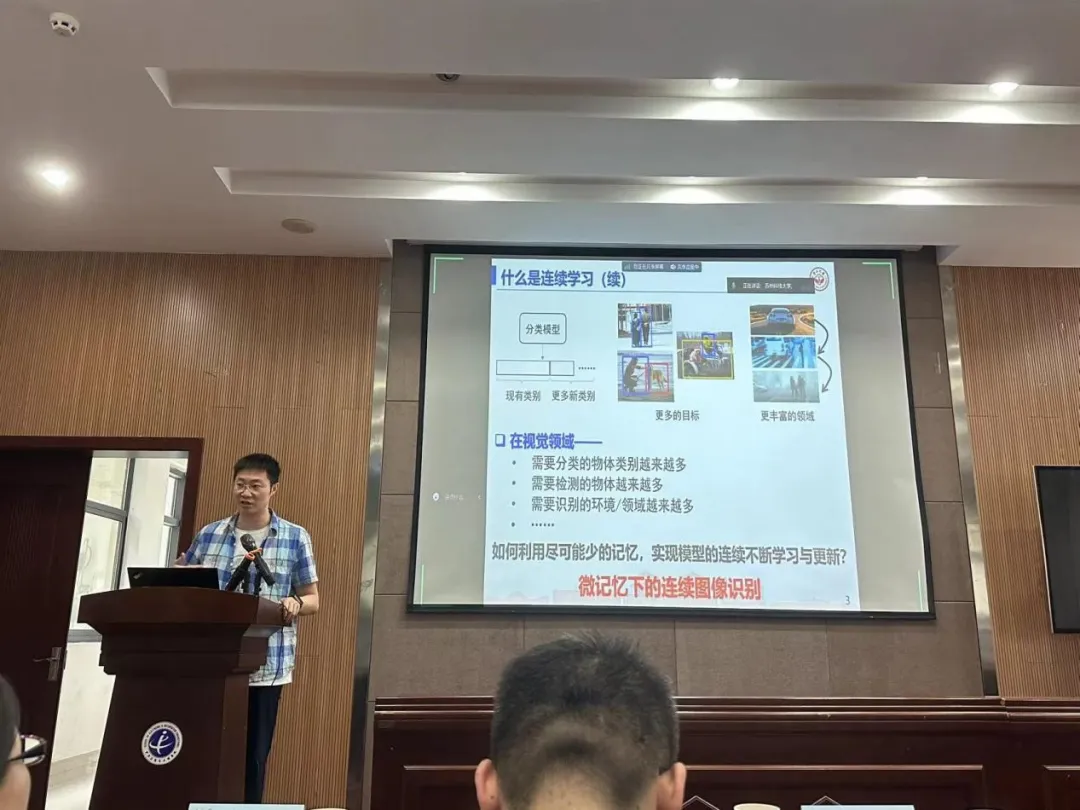

图 2 李玺教授作报告

李玺教授的主题报告围绕基于神经网络的continual learning方法,进行图像/视频数据的视觉特征学习。李老师从多个角度对这一主题进行了深入探讨,包括视觉特征的表达、深度学习模型的构建机制,以及对高层语义的理解等;介绍了近年来其团队中利用特征学习进行视觉语义分析和理解所做的一系列代表性的研究工作及其实际应用。

图 3 郑伟诗教授作报告

郑伟诗教授表明灾难性遗忘问题的存在使得深度学习模型针对新任务做优化后,原有任务的分类等性能产生严重的下降,不能满足我们对深度学习模型可以不断地针对新问题、新类别、新数据等展开持续性学习的需求。郑老师在报告中介绍如何利用无标注数据解决小记忆下的连续学习建模问题,以及如何利用提示建模解决零记忆环境下快速适配下游任务的连续学习问题,对近期的探索做了相关介绍和讨论。

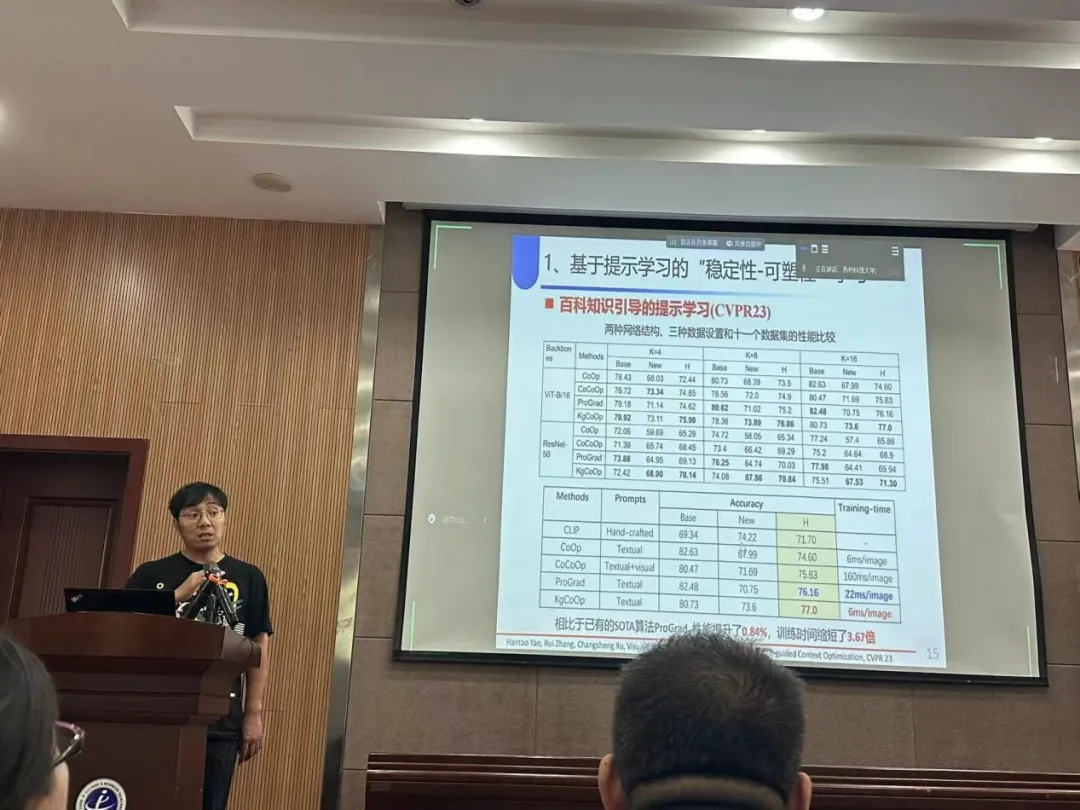

图 4 姚涵涛副研究员作报告

姚涵涛副研究员在报告中指出,持续学习中已学习知识迁移时应确保新旧知识间的“稳定性-可塑性”平衡,针对真实动态场景下数据稀缺、模态多样和内容动态的问题和挑战,介绍了基于提示学习的稳定性-可塑性学习以及面向图像文本数据和音视频数据的持续学习。此外,报告中还探讨多模态大模型时代下持续学习面临的挑战。

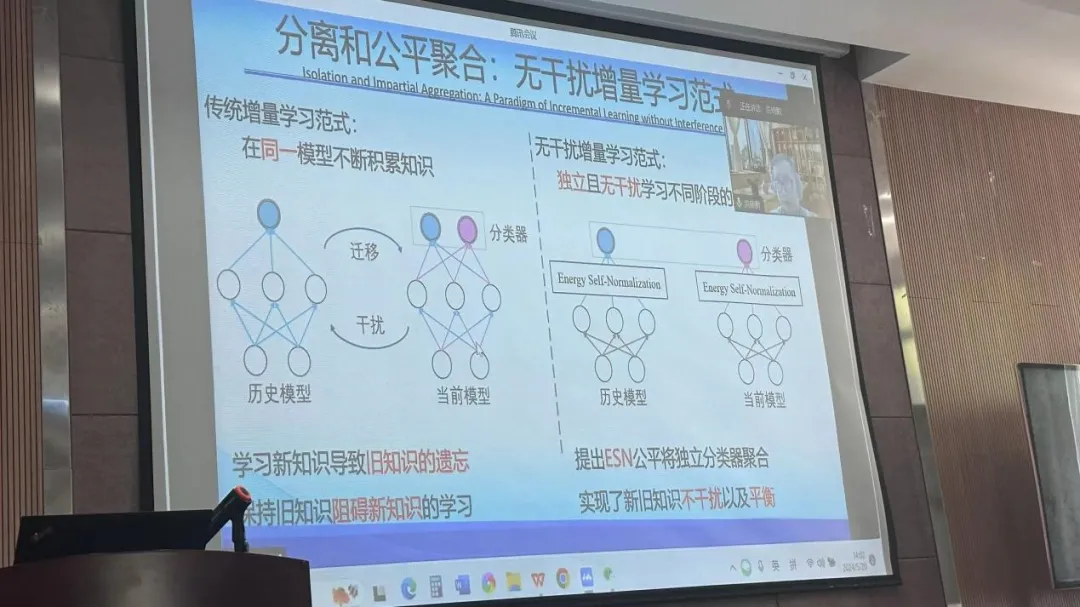

图 5 洪晓鹏教授作报告

洪晓鹏教授通过线上会议参与本次报告会,其主题报告聚焦于深度神经网络在学习新任务和知识时所面临的“灾难性遗忘”问题,旨在探讨如何保留旧知识从而完成知识的增量式积累,实现新旧知识不干扰以及平衡。报告中洪老师简要地介绍了目前主流方法,包括基于重放的遗忘抑制机制、基于提示学习的增量学习框架等,探讨在大模型时代出现的新趋势。

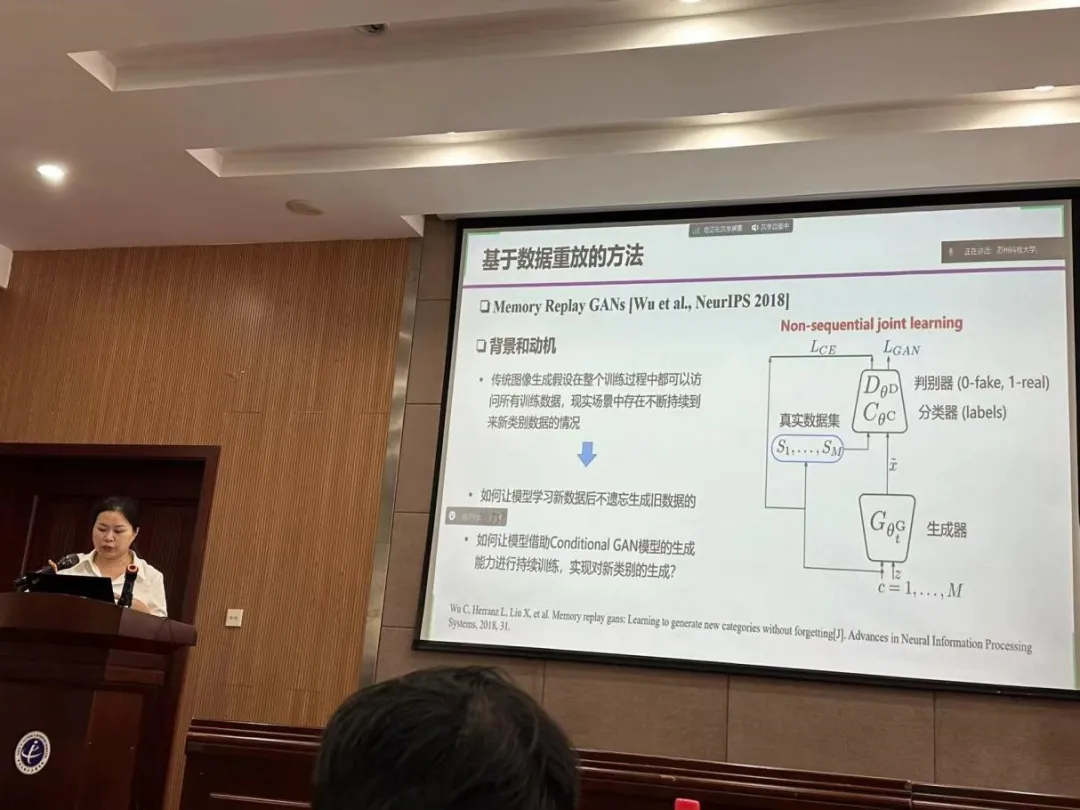

图 6 霍静副教授作报告

霍静副教授聚焦于面向图像生成模型的持续学习,介绍包括基于数据重放、基于元学习以及基于结构扩展等的面向图像生成模型的持续学习技术,分享了团队在在图像生成模型持续学习领域的具体研究进展,并对未来的研究方向提出了富有洞见的见解。

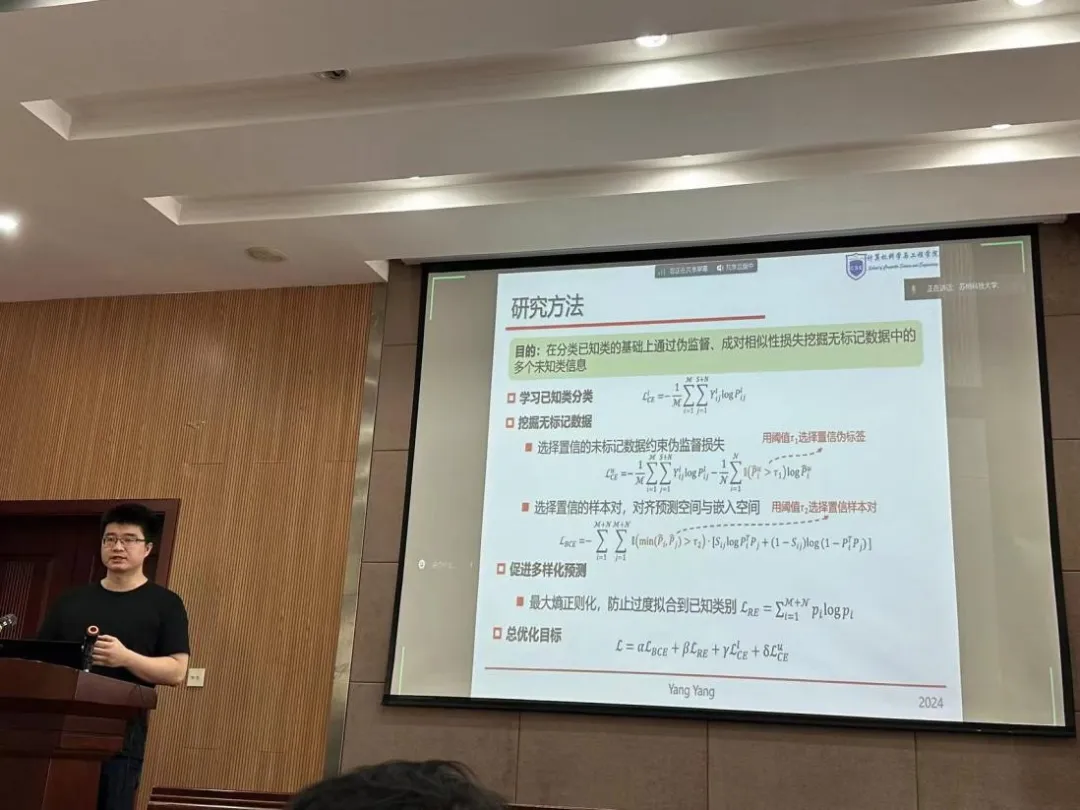

图 7 杨杨教授作报告

杨杨教授在报告中指出,不同于封闭静态条件下的传统数据挖掘,开放动态环境具有“多变”特性带来了一系列挑战,如标记分布的变化等。这些挑战造成开放集合决策难以及增量任务训练难。针对上述问题,杨老师团队提出了递进自变感知的稳健预测理论方法,构建了可适扩展的模型增量学习框架,实现了模型的鲁棒开放集预测以及稳健增量学习。

图 8 李爽副教授作报告

李爽副教授报告旨在探讨持续迁移学习的关键概念和技术,以及如何高效地在迁移任务场景中实现知识的增量式累积,深入讨论几个关键议题:数据高效迁移学习、持续迁移学习以及测试时自适应学习。李老师在报告中重点讲解如何在数据稀缺场景下、领域数据持续变化场景下以及测试阶段数据分布偏差情况下实现持续迁移学习。

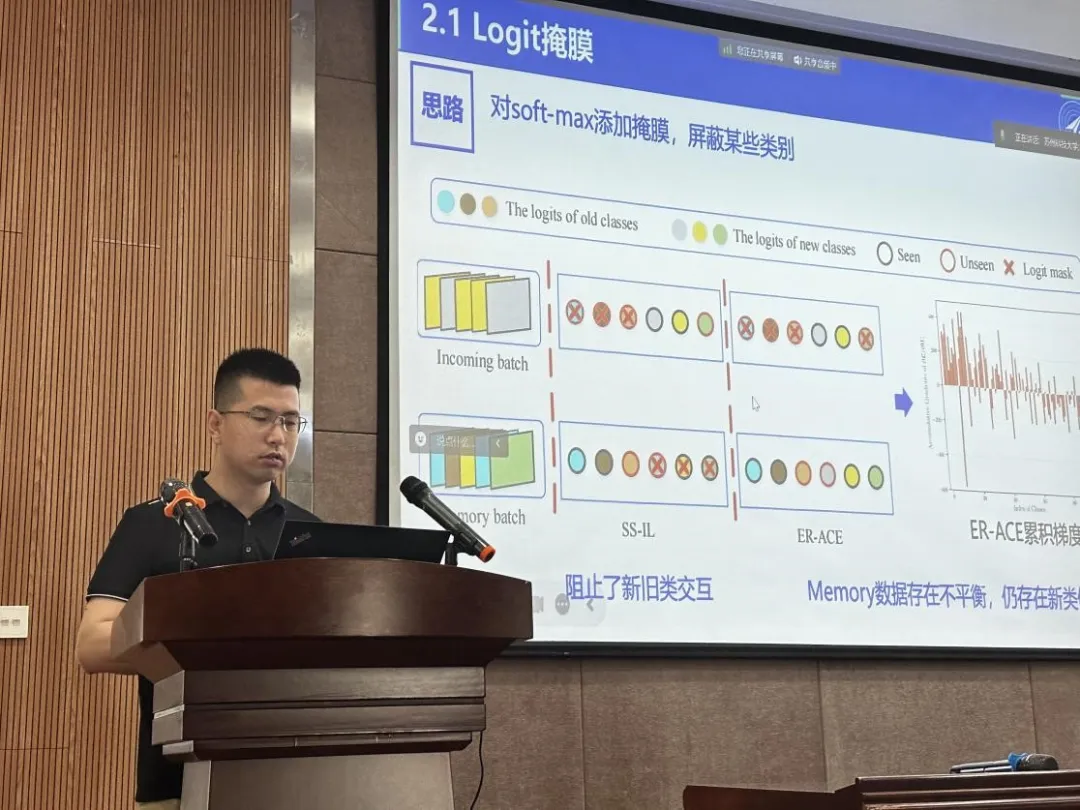

图 9 梁国强副教授作报告

梁国强副教授在其报告中指出,传统深度学习主要基于固定数据集进行训练推理,这在处理现实世界中不断变化的新需求时存在局限性。针对增量学习这一连续学习领域的典型问题,梁老师简要概述一些类增量学习的关键工作,包括基于随机增强、基于焦点转移以及基于提示的类增量学习。

参加本次活动的老师和同学认真聆听了报告,并与报告嘉宾热情地交流与互动,共同探讨学术内容。在活动的尾声,执行主席胡伏原教授上台发表了总结致辞,感谢各位专家的精彩报告以及线上线下师生们的热情参与,最后祝贺本次活动取得了圆满成功!

图 10 参会人员合影留念