活动预告

Visual Intelligence国际学者学术前沿在线研讨会将于11月2日举办

时间:2024-10-31 来源: 中国图象图形学学会

一、会议信息

1. 会议时间:2024年11月2日9:00-17:10

2. 会议举办方式 :#腾讯会议:283 470 967

3.会议直播:

欢迎关注CSIG官方视频号,观看直播

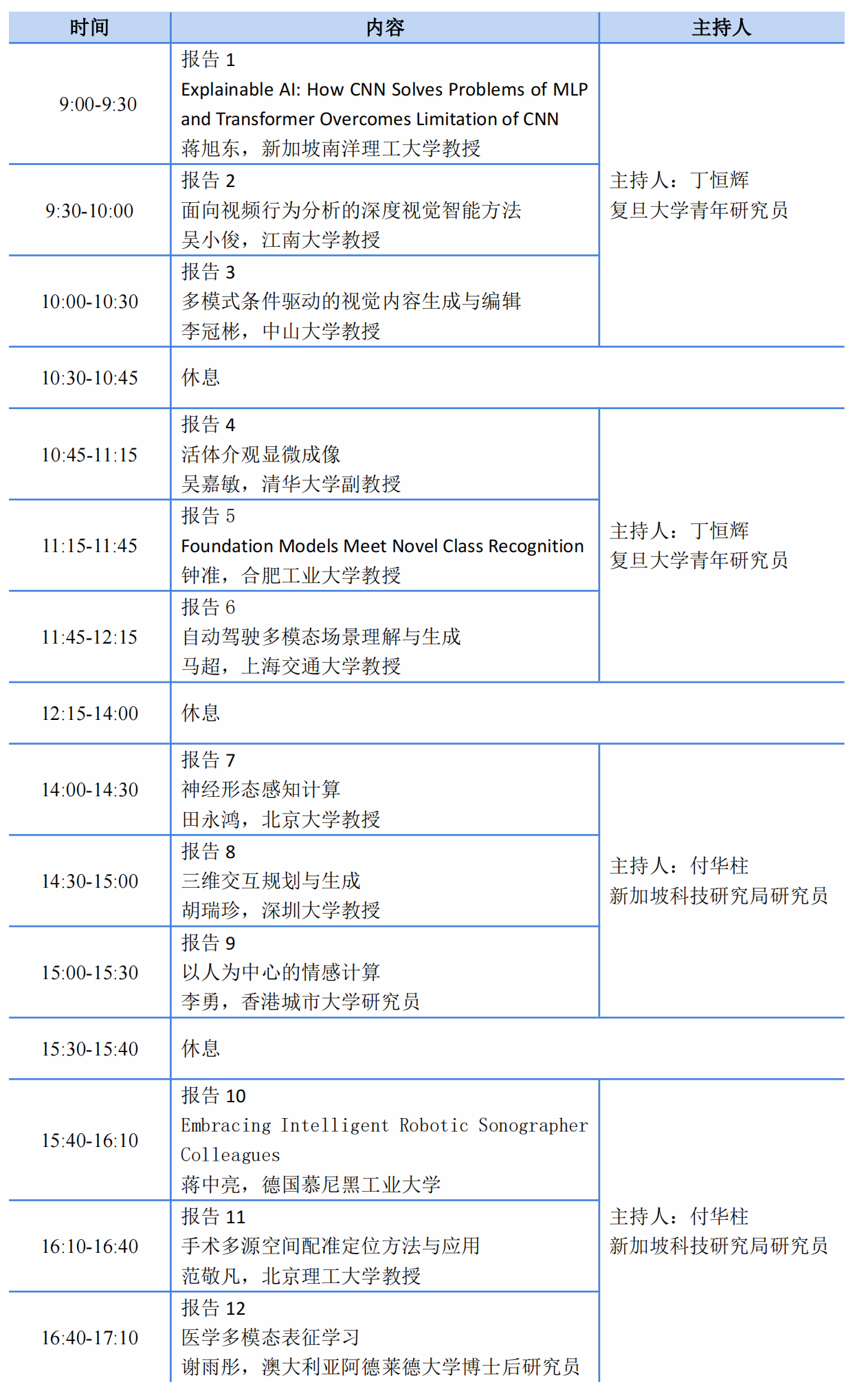

二、会议日程

报告嘉宾

蒋旭东

南洋理工大学教授

报告题目:Explainable AI: How CNN Solves Problems of MLP and Transformer Overcomes Limitation of CNN

报告摘要:Discovering knowledge from data has many applications in various artificial intelligence (AI) systems. Machine learning from the data is a solution to find right information from the high dimensional data. It is thus not a surprise that learning-based approaches emerge in various AI applications. The powerfulness of machine learning was already proven 30 years ago in the boom of neural networks but its successful application to the real world is just in recent years after the deep convolutional neural networks (CNN) have been developed. This is because the machine learning alone can only solve problems in the training data but the system is designed for the unknown data outside of the training set. This gap can be bridged by regularization: human knowledge guidance or interference to the machine learning. This speech will analyze these concepts and ideas from traditional neural networks to the very hot deep CNN and Transformer. It will answer the questions why the traditional neural networks fail to solve real world problems even after 30 years’intensive research and development and how CNN solves the problems of the traditional neural networks and how Transformer overcomes limitation of CNN and is now very successful in solving various real world AI problems.

个人简介:Xudong Jiang (IEEE Fellow) received the bachelor’s and master’s degrees from University of Electronic Science and Technology of China, and the Ph.D. degree from Helmut Schmidt University, Hamburg, Germany. From 1998 to 2004, he was with Institute for Infocomm Research, A*STAR, Singapore, as a Lead Scientist, and the Head of the Biometrics Laboratory. He joined Nanyang Technological University (NTU), Singapore, as a Faculty Member in 2004, where he served as the Director of the Centre for Information Security from 2005 to 2011. He is currently a professor with the School of EEE, NTU and serves as Director of Centre for Information Sciences and Systems. He has authored over 200 papers with over 60 papers in IEEE journals including 10 papers in T-PAMI and 18 papers in T-IP, and over 30 papers in top conferences such as CVPR/ICCV/ECCV/AAAI/ICLR/NeurIPS. His current research interests include computer vision, machine learning, pattern recognition, image processing, and biometrics. Dr. Jiang served as Associate Editors for IEEE SPL and IEEE T-IP. Currently he serves as a Senior Area Editor for IEEE T-IP and the Editor-in-Chief for IET Biometrics.

吴小俊

江南大学教授

报告题目:面向视频行为分析的深度视觉智能方法

报告摘要:视频行为分析对智慧城市有重要的应用价值。本报告主要介绍智慧城市中的视频行为分析的视觉智能方法。首先对视频行为分析与识别的深度学习方法作比较系统的介绍,然后介绍行为分析和识别的组合零次学习方法,并介绍这些方法在智慧城市安全方面的应用。

个人简介:吴小俊,IAPR Fellow、AAIA Fellow、AIIA Fellow、江南大学至善教授、江南大学研究生院院长、Josef Kittler AI研究院院长、教育部装发创新团队负责人、科技部中英AI联合实验室主任、教育部/江苏省AI国际合作联合实验室主任、教育部新世纪优秀人才、江苏省333工程第一层次人才。从事模式识别与人工智能的研究,在IEEE T-PAMI、IJCV、IEEE T-IP、NIPS、CVPR、ICCV、AAAI等国际期刊和会议上发表学术论文400余篇,出版学术著作5本。研究成果获得国内外学术奖励30余项;担任多项国家级重点项目负责人。现任IEEE智慧城市指导委员会委员、中国人工智能学会模式识别专委会副主任、教育部计算机类教学指导委员会委员、多本国际期刊主编或编委、中国图象图形学学会理事和江苏省人工智能学会副理事长等职。

李冠彬

中山大学教授

报告题目:多模式条件驱动的视觉内容生成与编辑

报告摘要:近年来,以扩散生成模型为代表的生成式AI模型能力日新月异,展现出令人瞩目的效果。在视觉内容生成及编辑领域,更符合用户意图及更具可控性的跨模态生成方法受到了学术界及产业界的广泛关注。已有的跨模态视觉生成方法在图像生成质量、美学感染力、跨模态结构及语义对齐、跨帧及多视角一致性等方面仍然存在诸多挑战。本次报告将围绕多模式条件驱动的可控视觉内容生成与编辑问题,介绍研究组从感知反馈学习、视频自监督一致性约束、蒸馏采样一致性、隐式参数对齐等角度实现用户意图一致的图像生成、视频虚拟试穿、图文提示引导的3D场景编辑以及多模式控制的数字人生成等方面的研究成果及相关应用。

个人简介:李冠彬,中山大学计算机学院教授,博士生导师,国家优秀青年基金获得者。主要研究领域为跨模态视觉感知、理解与生成。迄今为止累计发表CCF A类/中科院一区论文 160余篇,Google Scholar引用超过13000次。曾获得吴文俊人工智能优秀青年奖、ACM中国新星提名奖、中国图象图形学学会科学技术一等奖、ICCV2019最佳论文提名奖、CVPR 2024最佳论文候选、ICMR 2021最佳海报论文奖等荣誉。主持了包括国自然优青、面上、青年、广东省杰青、CCF-腾讯犀牛鸟科研基金、华为Mindspore学术基金、美团北斗科研合作基金等10多项科研项目。担任CSIG青工委副秘书长、CCF YOCSEF广州主席、广州计算机学会副秘书长、VALSE执行副主席等。担任CVPR、ECCV、AAAI等顶级会议领域主席(AC)或高级程序委员。担任The Visual Computer编委,获得8项CVPR、NeurIPS、ACM MM等国际顶级会议竞赛冠军。

吴嘉敏

清华大学副教授

报告题目: 活体介观显微成像

报告摘要:生物学现象的复杂性决定了体外模型无法完全模拟活体内的生物学过程,因此直接在活体原位对生物学动态过程进行跨尺度的长程快速观测对于揭示生物学本质至关重要。然而,当前活体荧光显微技术受到空间带宽积、三维感知速度、光毒性、噪声以及活体组织复杂环境等物理局限,远不足以满足对大范围百万级细胞相互作用,进行毫秒级动态观测的需求。针对这一难题,我们提出了扫描光场成像原理,实现了四维非相干光场的超精细感知与重构;提出了数字自适应光学架构,为解决光学像差百年难题提供了新路径;建立了曲面光场阵列架构,研制计算光场显微成像仪器,将活体成像的有效数据通量和时空分辨率均提升2个数量级,光毒性降低3个数量级,为系统性地研究哺乳动物在体大规模细胞间相互作用提供了利器。本次报告将介绍我们通过计算成像方法与人工智能算法突破传统显微成像局限,实现在体跨尺度高速高通量荧光显微成像的相关工作,及其在生命科学与医学领域的相关应用。

个人简介:吴嘉敏,清华大学自动化系副教授,博士生导师,清华-IDG/麦戈文脑科学研究院研究员。致力于计算成像、显微仪器与跨尺度数据理解的交叉研究。近五年以一作或通讯在Cell、Nature、Nature Biotechnology、Nature Photonics、Nature Methods等期刊发表论文20余篇,授权发明专利30余项,成果获2022年阿里巴巴达摩院青橙奖,清华大学学术新人奖,2022、2023中国光学十大进展等,任PhotoniX、IEEE T-CSVT编委,Light: Science & Applications客座主编。主持国家自然科学基金优青项目、科技部颠覆性技术专项等。

钟准

合肥工业大学教授

报告题目:Foundation Models Meet Novel Class Recognition

报告摘要:虽然深度学习在计算机视觉领域取得了显著突破,但在包含未知类别的开放场景中,仍然面临重大挑战。为了解决这一问题,近年来,异常类别检测和新类发现等领域受到了广泛关注。同时,近年来大模型的突破性进展极大推动了多个领域的发展,尤其是在零样本学习、图文生成、图像描述和图文推理等任务中表现突出。这引发了一个关键问题:大模型能否有效应用于或辅助异常类别检测和新类发现任务?本次汇报将介绍两种利用大模型支持异常类别检测和新类发现的方法:1)通过大语言模型生成未知类别信息,无需额外训练样本即可显著提升异常类别检测性能;2)通过视觉-语言模型的交互,构建具有语义可解释性的新类发现框架,为未知类识别任务在大模型时代提供了新的思路和方向。

个人简介:钟准,合肥工业大学教授。钟准博士于2019年在厦门大学获得工学博士学位,博士期间同时为悉尼科技大学联合培养博士。先后在意大利特伦托大学和英国诺丁汉大学从事博士后和助理教授工作。主要研究以可信计算机视觉为主题,在计算机科学领域发表多篇高水平论文,谷歌学术引用超过10,000次,其中两篇第一作者论文引用次数分别超过4,000次和1,800次,并且其中一篇被PaperDigest评为2020年最具影响力AAAI论文(排名第一)。连续三年入选斯坦福全球前2%顶尖科学家榜单以及AI 2000最具影响力(新星)学者提名。担任顶级会议CVPR、ECCV、ICML、NeurIPS、ICLR、ACM MM领域主席以及顶级期刊IJCV客座编委和CVIU编委。

马超

上海交通大学教授

报告题目:自动驾驶多模态场景理解与生成

报告摘要:多模态场景理解与生成是自动驾驶感知任务的核心与热点问题,本报告主要介绍多模态感知与生成任务的最新进展,汇报如何利用生成模型提升视觉场景感知能力,以及如何利用预训练模型进一步提升场景感知能力。

个人简介:马超,上海交通大学人工智能研究院教授,博士生导师。国家优青、上海市浦江人才、中国图象图形学学会优博。上海交通大学与加州大学默塞德分校联合培养博士。澳大利亚机器人视觉研究中心(阿德莱德大学)博士后研究员。主要研究计算机视觉问题。谷歌学术引用超过1.2万次,连续入选爱思唯尔中国高被引学者(2020-2023)。任中国图象图形学学会优博俱乐部主席、青年工作委员会副秘书长。担任CVPR 2024/2025、ICLR 2025领域主席,IEEE Transactions on Multimedia (TMM)、Journal of Artificial Intelligence Research (JAIR)、Image and Vision Computing(IVC)副编辑。获中国图象图形学学会青年科学家奖、MMM 2024唯一最佳论文奖、华为技术合作领域2021年度优秀技术成果奖。

田永鸿

北京大学教授

报告题目:神经形态感知计算

报告摘要:人工智能的终极研究目标是研究用于模拟、延伸和扩展人类智能处理能力的理论、方法与技术,最终开发出能以与人类智能相似的方式做出反应的机器。然而,由于真实世界是高度复杂、变化无穷的动态开放场景,使得感知计算技术总会面临新的、从未见过的困难场景,如极端光照/天气条件、高速运动对象等。大脑是一个高效智能的超大规模生物脉冲网络,对开放动态环境具有很强的感知认知能力,因此迫切需要借鉴大脑机制发展神经形态感知计算理论与方法。本报告将围绕这一主题,重点分享采用模拟人类视网膜的新型神经形态传感器,结合模拟人类视觉皮层的脉冲神经网络,打造“神经形态视觉+脉冲神经网络”的感知计算新架构方面所面临的挑战问题与研究进展。

个人简介:田永鸿,北京大学博雅特聘教授,IEEE Fellow,北京大学深圳研究生院信息工程学院院长,鹏城实验室网络智能部副主任兼云脑研究所所长,国家杰出青年基金获得者,2024年首批国家杰出青年基金延续资助计划获得者。主要研究方向为分布式机器学习、脉冲神经网络和神经形态视觉。累计主持国家重点研发计划项目、国基金杰青/重点/重大仪器项目等40 余项,累计发表学术论文350余篇,两获国际期刊和会议最佳论文奖;拥有美/中国发明专利110余项,获国家技术发明/进步二等奖各1次、教育部科技进步一等奖1次、中国电子学会一等奖各1次、2023年广东省科技进步特等奖、2022年IEEE标准奖章和标准新兴技术奖、2024年首届祖冲之奖重大成果奖,是2018年首届高校计算机专业优秀教师奖励计划获奖者。

胡瑞珍

深圳大学教授

报告题目:三维交互规划与生成

报告摘要:传统的三维感知往往依赖被动数据输入,仍处于计算智能和认知智能范畴,而作为新一代人工智能中的一个核心概念,“具身智能”强调了人类智能是在和环境交互中进化的,因此需要智能体通过主动感知场景、解析交互反馈、制定交互策略的方式来实现对于未知环境的探索和任务的执行,形成“感知-认知-行为”闭环,加速智能演化。然而,在实体空间直接进行智能演化具有很多限制,存在如训练交互场景单一使得交互策略泛化性差、交互反馈杂乱使得交互成本高、效率低等问题,因此往往可以先在三维数字空间中进行仿真交互学习,再迁移至真实世界。本报告将介绍虚拟智能体在数字空间中与环境交互行为的规划与生成方面系列工作,以及探讨相关策略在迁移至真实环境所面临的挑战和解决方案。

个人简介:胡瑞珍,深圳大学特聘教授,博士生导师,国家优秀青年科学基金、广东省杰出青年项目获得者。研究方向为计算机图形学,长期从事智能几何建模与处理方面的研究,发表ACM SIGGRAPH/TOG论文三十余篇;入选中科协青年人才托举工程;荣获亚洲图形学协会青年学者奖、全国几何设计与计算青年学者奖;担任期刊IEEE T-VCG、IEEE CG&A和Computers & Graphics等国际期刊编委;担任国际会议SGP 2024/CVM 2023/SMI 2020 Technical Paper、SIGGRAPH Asia Technical Communications and Posters以及EG 2024 Short Paper程序委员会主席,连续多年担任SIGGRAPH等大会程序委员会委员;担任中国计算机学会计算机辅助设计与图形学专委会常委、计算机图形学与混合现实在线平台(GAMES)执委会主席。

李勇

香港城市大学研究员

报告题目:以人为中心的情感计算

报告摘要:情感计算旨在弥合情感丰富的人类与缺乏情感的计算机之间的鸿沟,致力于构建具有“共情”能力的智能系统。其核心目标是赋予机器可靠感知与理解人类情绪的能力,相关技术已落地应用于辅助驾驶、智慧教育、智能养老看护等场景。然而,当前以人为中心的情感计算仍面临诸多关键挑战,如数据稀缺与复杂性、个体差异显著性以及输入模态的高度异构性。本次报告将重点介绍若干面向真实开放场景的细微情感特征学习方法,涵盖生成式(T-PAMI 2022、T-IP 2024)、判别式(T-AC 2023、T-IP 2023、T-PAMI 2023)和跨域跨模态的鲁棒情感感知方法(CVPR 2023 Highlight、ICCV/NIPS 2023、T-AC 2024)。此外,报告还将介绍在阿尔茨海默病患者康复训练过程中人眼视线估计的相关研究进展。所设计的一系列方法以个体情感的先验知识和定义为基础,合理利用大规模无标注人脸视频数据,有效捕捉单模态与多模态输入中的微弱情感信号,并力求具备良好的解释性。

个人简介:李勇,香港城市大学研究员,博士毕业于中国科学院计算技术研究所,主要从事人工智能与情感计算方面的研究工作。以第一作者在IEEE T-PAMI、IEEE T-IP、《中国图象图形学报》、IEEE T-AC、CVPR等国内外重要学术期刊和会议中发表论文十余篇,谷歌学术引用1950余次,其中发表于IEEE T-IP 2019的遮挡表情识别工作入选T-IP 2020 TOP-25下载论文。曾获2022年China MM最佳海报奖。入选2021年中国图象图形学学会优博,2022年人社部“香江学者”研究计划。

蒋中亮

慕尼黑工业大学研究员

报告题目:Embracing Intelligent Robotic Sonographer Colleagues

报告摘要:Medical ultrasound is crucial for modern clinical intervention. Owing to the advantages of being real-time, affordable, and ionizing radiation-free, ultrasound imaging has been widely used for biometric measurement and diagnosis, in particular of internal organs. However, traditional ultrasound examinations are highly operator-dependent, as it is challenging to accurately maintain or replicate acquisition parameters (the contact force and relative orientation between a probe and a tested object), even for experienced sonographers. The inter and intra-operator variations hamper the diagnosis accuracy, thereby further limiting the full clinical acceptance of ultrasound imaging. With the aim to improve clinical diagnostic accuracy and consistency, an intelligent robotic sonographer system is designed to automatically, accurately, and reliably accomplish image acquisition.

个人简介:蒋中亮博士就职于德国慕尼黑工业大学,担任CAMP研究室机器人与超声团队负责人。博士师从Prof. Nassir Navab,主要从事自动超声机器人成像与扫描研究,主要涉及领域包括医疗机器人系统、机器人学习、人机交互、医疗图像分割、基于传感器的手术状态实时感知等。目前发表机器人领域高质量期刊及会议30多篇,以第一作者或senior作者身份发表/接受的机器人领域高质量期刊及会议20余篇,如IJRR、MedIA、ARCRAS、TIE、TASE、TIM、TMRB、ICRA、IROS、MICCAI。获得MICCAI 2023最佳论文亚军奖。领导组织机器人辅助医疗成像RAMI系列workshop并担任机器人顶级会议ICRA20 2024-2025副主编。同时担任机器人顶刊IEEE TRO RAMI专刊客座编辑。

范敬凡

北京理工大学研究员

报告题目:手术多源空间配准定位方法与应用

报告摘要:微创手术决策依赖的CT、MRI等术前三维医学图像、患者体位、手术器械位姿、术中二维内镜影像等多源信息因采集方式不同,空间坐标不统一,即多源信息的空间异位性问题,导致手术过程面临术前多模医学图像关联分析难、手术器械与病灶位置定不准、皮下组织器官在术中实时影像中不可视的临床难题。对此,研究团队提出了由多模医学图像配准融合、高维空间位姿配准融合、术中影像透视融合组成的多源空间配准融合新方法,为微创手术导航信息共融提供理论支撑,取得了系列学术成果,显著扩充了手术规划信息量、提高了空间定位精准度、增强了重要组织器官可视性。

个人简介:范敬凡,北京理工大学光电学院研究员、博士生导师,入选国家优青、北京市科技新星、北京市海英人才及北京市青年人才托举工程。长期从事计算机视觉、增强现实手术导航相关领域研究,主持国家重点研发计划项目1项、课题1项,及国家自然科学基金项目3项,在IEEE T-IP、IEEE T-MI、MedIA等期刊和会议上发表论文90余篇,已参与完成多项医学图像辅助诊疗与手术导航系统的研发,相关知识产权已申报/授权60余项国家发明专利,成果转化获国家三类/二类医疗器械注册证6项。作为主要完成人获吴文俊人工智能科技进步一等奖、中国专利优秀奖。

谢雨彤

澳大利亚阿德莱德大学博士后研究员

报告题目:医学多模态表征学习

报告摘要:医学数据涵盖了来自日常医疗或临床试验项目的丰富健康信息,涉及多模态医学影像数据、文本诊断报告等多种类型。随着深度学习在过去十年的快速发展,多模态表征学习逐渐成为医学AI领域的核心方法,在标注数据有限的情况下展现出巨大潜力。然而,不同模态的医学数据之间存在着显著的差异,以及多模态配对数据的稀缺性等问题,这些因素都给有效的信息融合和精准表征带来了严峻的挑战。在本次研讨中,我将介绍我们在医学AI方面的最新研究进展,尤其是针对多模态医学数据处理的创新方法。我们专注于突破模态之间的差距,优化数据融合,以提升不同模态数据的交互表现。通过引入新颖的模型架构和学习策略,我们的方法在医学影像、文本等多模态数据的协同处理中展现出强大的适应性和可迁移性,能够更好地支持机器学习在复杂异构医疗数据上的应用。

个人简介:谢雨彤,澳大利亚阿德莱德大学机器学习研究所博士后研究员,即将于2025年1月入职阿联酋人工智能大学(MBZUAI)计算机视觉系任助理教授。于2016年和2021年在西北工业大学分别获得学士和博士学位。研究方向为医学影像智能计算,重点关注于有限标注下医学数据的高效分析和解读,多模态医学数据分析,医学通用数据分析模型。先后发表IEEE T-PAMI、T-MI、T-IP、MedIA、CVPR、ECCV、MICCAI等本领域顶级期刊/会议论文50余篇,谷歌学术被引用5000余次。入选“2023年度中国图象图形学学会博士学位论文激励计划”和CVPR 2024 Travel Award。担任MICCAI 2023/2024的Area Chair和多个顶级期刊和会议的审稿人,并获得了IEEE T-MI和CVPR 2023的杰出审稿人。

主持人

丁恒辉

复旦大学青年研究员

个人简介:丁恒辉,复旦大学青年研究员、博士生导师。入选国家高层次青年人才计划、上海市高层次人才计划。2020年于新加坡南洋理工大学获博士学位。主要从事计算机视觉、多模态大模型、视觉大数据分析、深度学习与人工智能等领域研究。过去6年内发表论文70多篇,包括50多篇CCF-A类国际顶级期刊和会议论文,如IEEE T-PAMI、CVPR、ICCV、NeurIPS等;20多篇CCF-B类期刊和会议论文,如ECCV、IEEE T-MM、PR等。应邀担任多个CCF-A类国际顶级会议的领域主席(AC),如CVPR、NeurIPS、ACM MM等,担任多个CCF-A类国际顶级会议的资深程序委员(SPC),如AAAI、IJCAI等。任上海市计算机学会副秘书长。

付华柱

新加坡科技研究局 (A*STAR) 主任研究员

个人简介:付华柱博士,现任新加坡科技研究局 (A*STAR) 高性能计算研究所 (IHPC) 主任研究员 (Principal Scientist)。主要研究方向为计算机视觉、医学图像分析以及可信人工智能等。至今已在 Nature Machine Intelligence、Nature Communications、IEEE T-PAMI、IEEE T-MI等期刊和会议上发表论文200余篇,Google Scholar 引用2万余次。曾获 2021年ICME最佳论文奖,2022年MICCAI OMIA 最佳论文,2023年MICCAI DeCAF 最佳论文等奖励。现担任IEEE Transactions on Medical Imaging (TMI)、IEEE Transactions on Neural Networks and Learning Systems (TNNLS)、Pattern Recognition、IEEE Journal of Biomedical and Health Informatics (JBHI)、Visual Intelligence等期刊编委 (Associate Editor),以及多个国际会议的领域主席。同时也是IEEE Bio Imaging and Signal Processing Technical Committee (BISP TC) 技术委员。(个人主页: https://hzfu.github.io/)